1 Θεωρητικό Υπόβαθρο

1.1 Ασυμπτωτική θεωρία

Η πλήρης κατανόηση της λειτουργίας των μεθόδων Monte Carlo επιτυγχάνεται με τη γνώση των βασικών τρόπων σύγκλισης ακολουθιών τυχαίων μεταβλητών, βασικών οριακών θεωρημάτων και ασυμπτωτικών ιδιοτήτων εκτιμητριών. Για το λόγο αυτό στην επόμενη παράγραφο παραθέτουμε τα πιο σημαντικά από αυτά.

1.1.1 Ασυμπτωτικές Ιδιότητες Εκτιμητριών

Η μελέτη εκτιμητριών σε στατιστικά μοντέλα οδηγεί φυσιολογικά στη διερεύνηση της ασυμπτωτικής έκφρασης των ιδιοτήτων που χαρακτηρίζουν μία καλή εκτιμήτρια. Όταν μία εκτιμήτρια δεν είναι αμερόληπτη, θα θέλαμε τουλάχιστον ασυμπτωτικά να απολαμβάνει αυτήν την ιδιότητα, δηλαδή να μηδενίζεται το μέσο σφάλμα της. Ο ασυμπτωτικός μηδενισμός θα θέλαμε να συμβαίνει και με το μέσο τετραγωνικό σφάλμα (ή το μέσο απόλυτο σφάλμα) που αποτελεί κριτήριο επιλογής εκτιμητριών. Έτσι οδηγούμαστε φυσιολογικά στις έννοιες της ασυμπτωτικής αμεροληψίας και της \(L^2\)-συνέπειας.

Ορισμός 1.1 Μία εκτιμήτρια \(\widehat{\theta}_n\) μιας παραμέτρου \(\theta\in \Theta\) καλείται ασυμπτωτικά αμερόληπτη εκτιμήτρια (α.α.ε.), αν η συνάρτηση μεροληψίας της \(b_n\), που ορίζεται από τη σχέση \(b_n(\theta)=\mathbf{E}_{\theta}(\widehat{\theta}_n)-\theta\), μηδενίζεται ασυμπτωτικά, δηλ., αν \[\begin{equation*} b_{n} \xrightarrow[n\rightarrow \infty]{p.w.} 0 \qquad \textrm{ή ισοδύναμα} \qquad \mathbf{E}_{\theta}(\widehat{\theta}_n) \xrightarrow[n\rightarrow \infty]{} \theta, \quad \textrm{για κάθε } \theta \in \Theta. \end{equation*}\]

Ορισμός 1.2 Μία εκτιμήτρια \(\widehat{\theta}_n\) μιας παραμέτρου \(\theta\in \Theta\) καλείται \(L^2\)-συνεπής, αν το μέσο τετραγωνικό της σφάλμα \(MSE_n\) μηδενίζεται ασυμπτωτικά, δηλ., αν \[\begin{equation*} MSE_{n} \xrightarrow[n\rightarrow \infty]{p.w.} 0 \qquad \textrm{ή ισοδύναμα} \qquad \mathbf{E}_{\theta}\left(\widehat{\theta}_n-\theta\right)^2 \xrightarrow[n\rightarrow \infty]{} 0, \quad \textrm{για κάθε } \theta \in \Theta. \end{equation*}\]

Είναι φανερό ότι οι παραπάνω ασυμπτωτικές ιδιότητες είναι επιθυμητές για μία εκτιμήτρια, αλλά δεν μας λένε τίποτα για την ταχύτητα σύγκλισης, η οποία πρέπει να εξετάζεται ταυτόχρονα. Σχετικά έχουμε τον ακόλουθο ορισμό.

Ορισμός 1.3 Μία ακολουθία \((\alpha_n)\) πραγματικών αριθμών λέγεται \(O(\beta_n)\) (κεφαλαίο όμικρον της \(\beta_n\)), όπου \((\beta_n)\) είναι μία συνήθως “απλούστερη” ακολουθία θετικών πραγματικών αριθμών, αν υπάρχει μία σταθερά \(M>0\), έτσι ώστε (τελικά για κάθε \(n\)) \[\begin{equation*} |\alpha_n| \leq M\beta_n. \end{equation*}\]

Ερμηνεία: H κλάση \(O(\beta_n)\) συμπεριλαμβάνει όλες τις ακολουθίες των οποίων η ασυμπτωτική συμπεριφορά κυριαρχείται από αυτήν που καθορίζεται από τη \((\beta_n)\). Είναι λοιπόν ένας συμβολισμός που αντιστοιχεί σε μία απλή περιγραφή του “χειρότερου” σεναρίου, αφού συνήθως εκφράζει κάποια πολυπλοκότητα αλγορίθμου (για \(\beta_n \rightarrow \infty\)) ή κάποιο σφάλμα (για \(\beta_n \rightarrow 0\)).

Παράδειγμα 1.1 Η κλάση \(O(1)\) είναι όλες οι φραγμένες ακολουθίες, η κλάση \(O(n)\) περιλαμβάνει όλες εκείνες που αποκλίνουν το πολύ γραμμικά στο \(+\infty\), ενώ η κλάση \(O(1/n)\) αφορά εκείνες που συγκλίνουν τουλάχιστον γραμμικά στο \(0\).

1.1.2 Τρόποι Σύγκλισης Ακολουθιών Τυχαίων Μεταβλητών

Σε αυτήν την ενότητα υπενθυμίζουμε τους σημαντικότερους τρόπους σύγκλισης ακολουθιών τ.μ., δίνουμε κάποιες πολυδιάστατες επεκτάσεις και υπενθυμίζουμε τους νόμους μεγάλων αριθμών και το κλασικό κεντρικό οριακό θεώρημα.

Ορισμός 1.4 Μία ακολουθία τ.μ. \((X_n)\) λέμε ότι συγκλίνει με πιθανότητα 1 ή σχεδόν βεβαίως, ή ισχυρά, σε μία τ.μ. \(X\), και γράφουμε \(X_n\xrightarrow[]{a.s.}X\), αν

\[\begin{equation*} \mathbf{P}\big(\big\{\omega \in \Omega: \exists \lim X_n(\omega) \ \textrm{και} \ \lim X_n(\omega)=X(\omega) \big\}\big) = 1. \end{equation*}\]

Ερμηνεία: Μία σύγκλιση με πιθανότητα 1 μας εξασφαλίζει ότι τυπικά κάθε πραγματοποίηση \((X_n(\omega))\) αντιστοιχεί σε μία συγκλίνουσα ακολουθία πραγματικών αριθμών. Αν γνωρίζουμε ότι η οριακή τυχαία μεταβλητή είναι η \(X\), τότε πρακτικά κάθε μονοπάτι οδηγεί στο \(X(\omega)\).

Το παραπάνω ενδεχόμενο γράφεται και συνοπτικά ως \(\{\lim X_n=X\}\) και έτσι σύντομα γράφουμε \(\mathbf{P}(\lim X_n=X)=1\) για να δηλώσουμε την παραπάνω σύγκλιση. Από τον ορισμό αυτό είναι φανερό ότι το μόνο που χρειάζεται να ορίσει κανείς είναι η σύγκλιση στο \(0\), αφού

\[\begin{equation*} X_n\xrightarrow[]{a.s.}X \quad \Longleftrightarrow \quad |X_n - X| \xrightarrow[]{a.s.} 0. \end{equation*}\]

Ο τρόπος αυτός σύγκλισης χαρακτηρίζει την ασυμπτωτική συμπεριφορά της ακολουθίας των δειγματικών μέσων μιας ακολουθίας ανεξάρτητων και ισόνομων τυχαίων μεταβλητών, έτσι όπως διατυπώνεται στον Ισχυρό Νόμο των Μεγάλων Αριθμών.

Θεώρημα 1.1 (Ισχυρός Νόμος Μεγάλων Αριθμών) Έστω \((X_n)\) μία ακολουθία ανεξάρτητων και ισόνομων τυχαίων μεταβλητών με \(\mathbf{E}|X_1|< +\infty\). Αν \(\overline{X}_n\) είναι ο δειγματικός μέσος, τότε

\[\begin{equation*} \overline{X}_n \xrightarrow[]{a.s.} \mathbf{E}(X_1). \end{equation*}\]

Στη στατιστική, ο παραπάνω τρόπος σύγκλισης μιας ακολουθίας τυχαίων μεταβλητών έχει μία άμεση εφαρμογή σε έναν ισχυρό τρόπο σύγκλισης εκτιμητριών στην υπό εκτίμηση παράμετρο. Είμαστε τώρα σε θέση να ορίσουμε την ισχυρή συνέπεια μιας εκτιμήτριας.

Ορισμός 1.5 Μία εκτιμήτρια \(\widehat{\theta}_n\) μιας παραμέτρου \(\theta\in \Theta\) καλείται ισχυρά συνεπής, αν \[\begin{equation*} \widehat{\theta}_n \xrightarrow[n\rightarrow \infty]{a.s.} \theta, \qquad \quad \textrm{για κάθε } \theta \in \Theta. \end{equation*}\]

Ερμηνεία: Όταν μία εκτιμήτρια είναι ισχυρά συνεπής, τότε πρακτικά κάθε δυνατό μονοπάτι εκτίμησης καταλήγει στην άγνωστη παράμετρο, όποια και αν είναι αυτή.

Στην περίπτωση που έχουμε πολυπαραμετρικά προβλήματα, μία εκτιμήτρια αντιστοιχεί σε μία ακολουθία τυχαίων διανυσμάτων. Οι παραπάνω έννοιες επεκτείνονται φυσιολογικά για διανύσματα. Ο ισχυρός τρόπος σύγκλισης επεκτείνεται εντελώς φυσιολογικά για ακολουθίες τυχαίων διανυσμάτων. Ο τυπικός ορισμός είναι όπως και στη μονοδιάστατη περίπτωση, απλά η έννοια του ορίου νοείται ως προς την ευκλείδια νόρμα.

Ορισμός 1.6 Μία ακολουθία τ.δ. \((X_n)\) λέμε ότι συγκλίνει με πιθανότητα 1 ή σχεδόν βεβαίως, ή ισχυρά, σε ένα τ.δ. \(X\), και γράφουμε \(X_n\xrightarrow[]{a.s.}X\), αν

\[\begin{equation*} ||X_n - X|| \xrightarrow[]{a.s.} 0 \quad \textrm{ή ισοδύναμα} \quad \mathbf{P}(\lim X_n=X)=1. \end{equation*}\]

Ασθενέστερη της παραπάνω σύγκλισης είναι η στοχαστική σύγκλιση.

Ορισμός 1.7 Μία ακολουθία τ.μ. \((X_n)\) λέμε ότι συγκλίνει κατά πιθανότητα ή στοχαστικά σε μία τ.μ. \(X\), και γράφουμε \(X_n\xrightarrow[]{p}X\), αν για κάθε \(\epsilon > 0\)

\[\begin{equation*} \mathbf{P}\big(\lvert \, X_n - X \rvert > \epsilon \big) \xrightarrow[n \rightarrow\infty]{} 0 \quad \textrm{ή ισοδύναμα} \quad \mathbf{P}\big(\lvert \, X_n - X \rvert \leq \epsilon \big) \xrightarrow[n \rightarrow\infty]{} 1. \end{equation*}\]

Όπως για την ισχυρή σύγκλιση, έτσι και για τη στοχαστική, έχουμε

\[\begin{equation*} X_n\xrightarrow[]{p}X \quad \Longleftrightarrow \quad |X_n - X|\xrightarrow[]{p} 0. \end{equation*}\]

Ο τρόπος αυτός σύγκλισης εμφανίζεται στην ασυμπτωτική συμπεριφορά της ακολουθίας των δειγματικών μέσων μιας ακολουθίας ανεξάρτητων και ισόνομων τυχαίων μεταβλητών, έτσι όπως διατυπώνεται στον Ασθενή Νόμο των Μεγάλων Αριθμών.

Θεώρημα 1.2 (Ασθενής Νόμος Μεγάλων Αριθμών) Έστω \((X_n)\) μία ακολουθία ανεξάρτητων και ισόνομων τυχαίων μεταβλητών με \(\mathbf{E}|X_1|< +\infty\). Αν \(\overline{X}_n\) είναι ο δειγματικός μέσος, τότε

\[\begin{equation*} \overline{X}_n \xrightarrow[]{p} \mathbf{E}(X_1). \end{equation*}\]

Στη στατιστική, ο παραπάνω τρόπος σύγκλισης μιας ακολουθίας τυχαίων μεταβλητών έχει μία άμεση εφαρμογή σε έναν ασθενέστερο τρόπο σύγκλισης εκτιμητριών στην υπό εκτίμηση παράμετρο από αυτόν που αντιστοιχεί στην ισχυρή συνέπεια. Είμαστε τώρα σε θέση να ορίσουμε την (ασθενή) συνέπεια μιας εκτιμήτριας.

Ορισμός 1.8 Μία εκτιμήτρια \(\widehat{\theta}_n\) μιας παραμέτρου \(\theta\in \Theta\) καλείται (ασθενώς) συνεπής, αν \[\begin{equation*} \widehat{\theta}_n \xrightarrow[n\rightarrow \infty]{p} \theta, \qquad \quad \textrm{για κάθε } \theta \in \Theta. \end{equation*}\]

Ερμηνεία: Όταν μία εκτιμήτρια είναι συνεπής, τότε θεωρητικά, καθώς το μέγεθος του δείγματος αυξάνει, γίνεται όλο και πιο σπάνιο το ενδεχόμενο να βρεθεί η εκτιμήτρια \(\epsilon\)-μακριά από την άγνωστη παράμετρο, όποια και αν είναι αυτή. Ισοδύναμα, γίνεται όλο και πιο συχνό το ενδεχόμενο να βρεθεί η εκτιμήτρια \(\epsilon\)-κοντά στην υπό εκτίμηση παράμετρο.

Καθώς θέλουμε να αντιμετωπίσουμε και προβλήματα πολυπαραμετρικά οδηγούμαστε στην ακόλουθη επέκταση της στοχαστικής σύγκλισης, όπως κάναμε και για την ισχυρή.

Ορισμός 1.9 Μία ακολουθία τ.δ. \((X_n)\) λέμε ότι συγκλίνει κατά πιθανότητα ή στοχαστικά σε ένα τ.δ. \(X\), και γράφουμε \(X_n\xrightarrow[]{p}X\), αν

\[\begin{equation*} ||X_n - X|| \xrightarrow[]{p} 0. \end{equation*}\]

Παρόλο που η ισχυρή και η στοχαστική σύγκλιση εμπλέκουν τη συμπεριφορά της νόρμας στον \(\mathbb{R}^{d}\), η μελέτη τους απλοποιείται και είναι ισοδύναμη με την εξέταση των αντίστοιχων ορίων κατά συνιστώσα. Συγκεκριμένα, είναι εύκολο να δειχθεί το επόμενο αποτέλεσμα.

Πρόταση 1.1 Έστω \((X_n)=(X_{n,1},X_{n,2},\ldots,X_{n,d})\) μία ακολουθία τυχαίων διανυσμάτων και \(X=(X_{1},X_{2},\ldots,X_{d})\) ένα ακόμα τυχαίο διάνυσμα. Τότε, \[\begin{equation*} X_n \xrightarrow[]{a.s./p} X \quad \Longleftrightarrow \quad X_{n,i} \xrightarrow[]{a.s./p} X_{i}, \quad \textrm{για κάθε} \ i=1,2,\ldots,d, \end{equation*}\] δηλαδή, και οι δύο συγκλίσεις είναι ισοδύναμες με τις αντίστοιχες συγκλίσεις κατά συνιστώσα.

Με βάση την παραπάνω πρόταση καταλήγουμε άμεσα σε πολυδιάστατες επεκτάσεις του Ισχυρού Νόμου των Μεγάλων Αριθμών (Ι.Ν.Μ.Α.), αλλά και του Ασθενή Νόμου των Μεγάλων Αριθμών (Α.Ν.Μ.Α.).

Πόρισμα 1.1 Έστω \((X_n)\) μία ακολουθία ανεξάρτητων και ισόνομων τ.δ. με \(\mathbf{E}||X_1||< +\infty\). Αν \(\overline{X}_n\) είναι ο δειγματικός μέσος, τότε

\[\begin{equation*} \overline{X}_n \xrightarrow[]{a.s.} \mathbf{E}(X_1) \qquad (\textrm{I.N.M.A}) \end{equation*}\]

και

\[\begin{equation*} \overline{X}_n \xrightarrow[]{p} \mathbf{E}(X_1) \qquad (\textrm{Α.N.M.A}) \end{equation*}\]

Όπως βέβαια και στη μονοδιάστατη περίπτωση, ο Α.Ν.Μ.Α. είναι συνέπεια του Ι.Ν.Μ.Α., καθώς η στοχαστική σύγκλιση προκύπτει άμεσα από την ισχυρή.

Πιο σύνθετη είναι η κατάσταση στη σύγκλιση κατά κατανομή. Η σημασία βέβαια της σύγκλισης αυτής είναι τεράστια και έχει πολλές εφαρμογές, ιδιαίτερα δε στη Στατιστική. Έτσι έχουν δοθεί αρκετοί ισοδύναμοι χαρακτηρισμοί. Υπενθυμίζουμε πρώτα τον ορισμό που συνήθως δίνεται για ακολουθίες πραγματικών τυχαίων μεταβλητών.

Ορισμός 1.10 Μία ακολουθία τ.μ. \((X_n)\) λέμε ότι συγκλίνει κατά κατανομή ή ασθενώς σε μία τ.μ. \(X\), και γράφουμε \(X_n\xrightarrow[]{d}X\), αν για κάθε \(x\in \mathbb{R}\) με \(F(x-)=F(x)\) (σημεία συνεχείας της \(F\)),

\[\begin{equation*} F_{n}(x) \xrightarrow[n \rightarrow \infty]{} F(x), \end{equation*}\]

όπου \(F_n\) είναι η συνάρτηση κατανομής της \(X_n\) και \(F\) είναι η σ.κ. της \(X\).

Η συνάρτηση κατανομής είναι ένα βολικό αντικείμενο περιγραφής της κατανομής μιας πραγματικής τ.μ. (επεκτείνεται και στις διανυσματικές), με το πλεονέκτημα ότι ορίζεται με ενιαίο τρόπο για συνεχείς και διακριτές τ.μ..

Στην ισχυρή και στη στοχαστική σύγκλιση, όλες οι τ.μ. πρέπει να είναι ορισμένες στον ίδιο χώρο πιθανότητας. Στην ασθενή σύγκλιση αυτό δεν είναι απαραίτητο, αλλά δεν θα επεκταθούμε άλλο σε αυτό το θέμα.

Στην παρακάτω πρόταση υπενθυμίζουμε τη σχέση που έχουν οι διάφοροι τρόποι σύγκλισης μεταξύ τους.

Πρόταση 1.2 Έστω \((X_n)\) μία ακολουθία τ.μ. και \(X\) μία ακόμα τ.μ. ορισμένες σε κοινό χώρο πιθανότητας. Τότε

\[\begin{equation*} X_n \xrightarrow[]{a.s.}X \ \ \Rightarrow \ \ X_n \xrightarrow[]{p} X \ \ \Rightarrow \ \ X_n \xrightarrow[]{d} X. \end{equation*}\]

Στην ειδική περίπτωση που \(X\stackrel{a.s.}=c\), όπου \(c\) σταθερά, τότε \[\begin{equation*} X_n \xrightarrow[]{p} c \ \Longleftrightarrow \ X_n \xrightarrow[]{d} c. \end{equation*}\]

Υπενθυμίζουμε τώρα το κλασικό Κεντρικό Οριακό Θεώρημα (Lindeberg-L'evy) σε δύο ισοδύναμες μορφές.

Πρόταση 1.3 Έστω \((X_n)\) μία ακολουθία ανεξάρτητων και ισόνομων τ.μ. με \(\mathbf{E}(X_1 ^{2})< +\infty\). Θέτουμε \(\mu_X=\mathbf{E}(X_1)\) και \(\sigma_{X}^{2}=\mathbf{V}(X_1)\) την κοινή τους μέση τιμή και διασπορά αντίστοιχα. Αν \(\left(\overline{X}_n\right)\) είναι η ακολουθία των δειγματικών μέσων και \((S_n)\) η ακολουθία των μερικών αθροισμάτων της \((X_n)\), τότε

\[\begin{equation*} \sqrt{n}\left(\,\overline{X}_n-\mu_X\right) \xrightarrow[]{d} \mathcal{N}\,(0, \, \sigma_{X}^{2}), \end{equation*}\]

και

\[\begin{equation*} \frac{S_n- n\,\mu_X}{\sqrt{n}} \xrightarrow[]{d} \mathcal{N}\,(0, \, \sigma_{X}^{2}). \end{equation*}\]

Για να είναι η ασυμπτωτικά κανονική κατανομή μη εκφυλισμένη (όχι σταθερά), υποθέτουμε επιπλέον ότι \(\sigma_{X}^{2}>0\).

Το επόμενο θεώρημα είναι πολύ χρήσιμο για να βρίσκουμε τις ασυμπτωτικές ιδιότητες συνεχών συναρτήσεων τυχαίων μεταβλητών ή τυχαίων διανυσμάτων, όταν γνωρίζουμε τις ασυμπτωτικές ιδιότητες των τελευταίων. Μπορούμε να το δούμε και ως γενίκευση της αρχής της μεταφοράς.

Θεώρημα 1.3 (Θεώρημα Συνεχούς Απεικόνισης) Έστω \((X_n)\), \(X\) τυχαία διανύσματα με τιμές στον \(\mathbb{R}^d\). Αν \(g: \mathbb{R}^d\rightarrow \mathbb{R}^{\ell}\) και η \(g\) είναι συνεχής σε κάποιο \(C\in \mathcal{B}(\mathbb{R}^d)\), τέτοιο ώστε \(\textbf{P}(X\in C)=1\), τότε

\[\begin{equation}\label{continuity-theorem} X_n \xrightarrow{a.s./p/d} X \quad \Rightarrow \quad g(X_n) \xrightarrow{a.s./p/d} g(X). \end{equation}\]

Λήμμα 1.1 Αν \(X_n\xrightarrow{d} X\) και \(X_n-Y_n\xrightarrow{p} 0\), τότε \(Y_n\xrightarrow{d}X\).

Λήμμα 1.2 Αν \(X_n\xrightarrow{d} X\) και \(Y_n\xrightarrow{p} c\), τότε \((X_n, Y_n)\xrightarrow{d} (X, c)\).

Θεώρημα 1.4 (Λήμμα Slutsky) Αν \(X_n, Y_n, X, c\) τυχαία διανύσματα ή πίνακες με κατάλληλες διαστάσεις και \(X_n\xrightarrow{d} X\), \(Y_n\xrightarrow{p}c\), τότε \(X_n+Y_n\xrightarrow{d} X+c\), \(Y_n X_n \xrightarrow{d} cX\) και, αν \(c\) αντιστρέψιμος, τότε \(Y_n^{-1} X_n \xrightarrow{d} c^{-1} X\).

Παρατήρηση:. Αν \(X_n\xrightarrow{as/p} X\), \(Y_n\xrightarrow{as/p} Y\), τότε \(X_n+Y_n \xrightarrow{as/p} X+Y\), \(X_n Y_n \xrightarrow{as/p} XY\) και \(Y_n^{-1} X_n \xrightarrow{as/p} Y^{-1} X\), αν υπάρχουν τα αντίστροφα. Γενικά όμως δεν ισχύει για τη σύγκλιση κατά κατανομή.

H μέθοδος δέλτα είναι μία από τις πιο χρήσιμες μεθόδους για να βρίσκουμε την ασυμπτωτική κατανομή μιας εκτιμήτριας που μπορεί να εκφραστεί ως διαφορίσιμη συναρτηση κάποιας άλλης εκτιμήτριας (συνήθως μέσω plug-in) της οποίας γνωρίζουμε την ασυμπτωτική της κατανομή. Παρουσιάζουμε τη μέθοδο κατ’ευθείαν στην πολυδιάστατη περίπτωση.

Θεώρημα 1.5 (Μέθοδος Δέλτα) Έστω \(\phi: D_{\phi}\subset \mathbb{R}^d \rightarrow \mathbb{R}^m\) μία διαφορίσιμη απεικόνιση στο \(\theta\in D_{\phi}\) και \(X_n\in D_{\phi}\) για κάθε \(n\geq 1\). Αν \((r_n)\) ακολουθία με \(r_n\rightarrow \infty\) και \(r_n(X_n-\theta)\xrightarrow{d} X\), τότε \[\begin{equation}\label{delta} r_n\Big(\phi(X_n)-\phi(\theta)\Big)\, \xrightarrow{d}\, \Phi'_{\theta} \cdot X, \end{equation}\] όπου \(\Phi'_{\theta} := \left(\dfrac{\partial \phi_i}{\partial x_j} \right)\Bigg\vert_{x=\theta}\) είναι ο Ιακωβιανός πίνακας της \(\phi\) υπολογισμένος στο \(\theta\). Ειδικά για \(d=m=1\), έχουμε \[\begin{equation}\label{delta_alternative_1} r_n\Big(\phi(X_n)-\phi(\theta)\Big)\, \xrightarrow{d}\, \phi^{'}(\theta)\cdot X, \end{equation}\]

Σε πολλές περιπτώσεις έχουμε \(r_n=\sqrt{n}\) και οριακή κανονική κατανομή.

Πόρισμα 1.2 Με υποθέσεις όπως πριν, αν \(\sqrt{n}(X_n-\theta)\xrightarrow{d} N_d(0, \Sigma),\) τότε \[\begin{equation}\label{delta_corollary} \sqrt{n}\, \Big(\phi(X_n)-\phi(\theta)\Big)\, \xrightarrow{d}\, N_d\Big( 0, \Phi'_{\theta}\,\Sigma\, (\Phi'_{\theta})^{\top} \Big). \end{equation}\] Ειδικά για \(d=m=1\) και \(\Sigma=\sigma^2\), έχουμε \[\begin{equation}\label{delta_corollary2} \sqrt{n}\, \Big(\phi(X_n)-\phi(\theta)\Big)\, \xrightarrow{d}\, N\Big( 0, (\phi'(\theta))^2\,\sigma^2 \Big). \end{equation}\]

1.2 Τυχαία Διανύσματα

1.2.1 Κατανομή τυχαίων διανυσμάτων

Η έννοια της συνάρτησης κατανομής επεκτείνεται φυσιολογικά και για τυχαία διανύσματα. Σε ότι ακολουθεί θεωρούμε το \(\mathbb{R}^{d}\) εφοδιασμένο με τη σχέση μερικής διάταξης που προκύπτει μέσω της σχέσης \(x\leq y\), αν και μόνο αν, \(x_i\leq y_i\), για κάθε \(1\leq i \leq d\).

Ορισμός 1.11 Έστω \(X\) ένα τυχαίο διάνυσμα με τιμές στον \(\mathbb{R}^{d}\). Η συνάρτηση \(F_X:\mathbb{R}^{d}\rightarrow [0,1]\), όπου

\[\begin{equation*} F_X(x):=\mathbf{P}(X\leq x)=\mathbf{P}(X_1\leq x_1,X_2 \leq x_2,\ldots,X_d \leq x_d) = \mathbf{P}\left(\bigcap_{i=1}^{d}\{X_i \leq x_i\}\right), \end{equation*}\]

λέγεται συνάρτηση κατανομής του τ.δ. \(X\) ή των \(X_1,X_2,\ldots,X_d\). Όταν θέλουμε να δώσουμε έμφαση στις συνιστώσες τ.μ. γράφεται και ως \(F_{X_1,\ldots,X_n}(x_1,\ldots,x_n)\).

Δίνουμε παρακάτω χωρίς απόδειξη τρεις χρήσιμους χαρακτηρισμούς της ισονομίας τυχαίων διανυσμάτων.

Πρόταση 1.4 Δύο τυχαία διανύσματα \(X\),\(Y\) είναι ισόνομα, αν και μόνο αν,

- \(F_X = F_Y\), δηλαδή, έχουν κοινή συνάρτηση κατανομής.

- \(u^{\top}X \stackrel{d}{=} u^{\top}Y\), για κάθε \(u\in \mathbb{R}^{d}\), δηλαδή, κάθε γραμμικός συνδιασμός των συνιστωσών της \(X\) είναι ισόνομος με τον αντίστοιχο γραμμικό συνδιασμό των συνιστωσών της \(Y\).

- \(\mathbf{E}[f(X)]=\mathbf{E}[f(Y)]\), για κάθε \(f:\mathbb{R}^{d}\rightarrow \mathbb{R}\) συνεχή και φραγμένη συνάρτηση.

Ο πρώτος χαρακτηρισμός είναι φυσιολογική γενίκευση του αντίστοιχου χαρακτηρισμού για μονοδιάστατες τ.μ.. Ο δεύτερος είναι αρκετά χρήσιμος σε αποδείξεις και δίνει τη δυνατότητα χαρακτηρισμού της κατανομής ενός τ.δ. μέσω της γνώσης μιας (άπειρης) οικογένειας κατανομών μονοδιάστατων τ.μ. που προκύπτουν μάλιστα μόνο μέσω γραμμικών μετασχηματισμών. Είναι μάλιστα θεωρητικά πιο γόνιμος, αφού επεκτείνεται και σε απειροδιάστατους διανυσματικούς χώρους με νόρμα μέσω της έννοιας του γραμμικού φραγμένου τελεστή (αντικείμενο μελέτης της συναρτησιακής ανάλυσης). Ο τελευταίος χαρακτηρισμός είναι ο πιο γενικός και μπορεί να χρησιμοποιηθεί γενικότερα σε μετρικούς χώρους.

1.2.2 Μέση τιμή και διασπορά τυχαίων διανυσμάτων

Οι έννοιες της μέσης τιμής και της διασποράς, όπως και της ροπής οποιασδήποτε τάξης, επεκτείνονται σε τυχαία διανύσματα. Θα περιοριστούμε εδώ μόνο στη μέση τιμή και τη διασπορά που είναι και οι πιο χρήσιμες. Είναι φανερό από τον χαρακτηρισμό της κατανομής που δίνεται στην Πρόταση 1.4-(2) ότι μία επέκταση κάποιας έννοιας στην πολυδιάστατη περίπτωση θα μπορούσε να εμπνέεται απο την εφαρμογή της αντίστοιχης έννοιας στη μονοδιάστατη περίπτωση σε όλους τους γραμμικούς συνδιασμούς \(u^{\top}X\). Λόγω της γραμμικότητας της μέσης τιμής, η μέση τιμή \(\mathbf{E}(u^{\top}X)\) καθορίζεται πλήρως από το διάνυσμα των μέσων τιμών \(\left(\mathbf{E}(X_1),\ldots,\mathbf{E}(X_d)\right)\). Στην περίπτωση της διασποράς, δεν αρκεί η γνώση των συνιστωσών διασπορών, αλλά χρειάζεται η γνώση και των συνδιακυμάνσεων \(\text{Cov}(X_i,X_j)\). Παρόλα αυτά, η γνώση του πίνακα \(\left(\text{Cov}(X_i,X_j)\right)_{i,j}\) είναι αρκετή για τον καθορισμό της διασποράς \(\mathbf{V}(u^{\top}X)\), δηλαδή, της διασποράς όλων των γραμμικών συνδιασμών της \(X\). Οδηγούμαστε λοιπόν στους επόμενους ορισμούς.

Ορισμός 1.12 Έστω \(X\) ένα τυχαίο διάνυσμα με τιμές στον \(\mathbb{R}^{d}\).

Αν \(\mathbf{E}|X_i|< +\infty\) για κάθε \(1\leq i \leq d\), τότε λέμε ότι το \(X\) έχει μέση τιμή \(\mathbf{E}(X)\) που ορίζεται από τη σχέση: \[\begin{equation*} \mu_X \equiv \mathbf{E}(X):=\left(\mathbf{E}(X_1),\mathbf{E}(X_2), \ldots, \mathbf{E}(X_d)\right). \end{equation*}\] Η συνθήκη ύπαρξης μέσης τιμής είναι ισοδύναμη με τη συνθήκη \(\mathbf{E}||X||< +\infty\), όπου \(||\cdot||\) είναι η ευκλείδια νόρμα στον \(\mathbb{R}^{d}\), την οποία και θα χρησιμοποιούμε για απλότητα.

Αν \(\mathbf{E}(X_i^2)< +\infty\) για κάθε \(1\leq i \leq d\), τότε ορίζουμε ως διασπορά του \(X\) τον πίνακα: \[\begin{equation*} \Sigma_X \equiv \mathbf{V}(X):=\left(\text{Cov}(X_i,X_j)\right)_{1\leq i,j \leq d}. \end{equation*}\] Ο πίνακας \(\mathbf{V}(X)\) λέγεται και πίνακας διασπορών–συνδιασπορών (για εμφανείς λόγους) ή πίνακας συνδιακύμανσης και συμβολίζεται και με \(\text{Cov}(X)\). Η συνθήκη ύπαρξης της διασποράς είναι ισοδύναμη με τη συνθήκη \(\mathbf{E}||X||^{2}< +\infty\), την οποία και θα χρησιμοποιούμε για απλότητα.

Αν \(Y\) είναι ένα ακόμα τυχαίο διάνυσμα με τιμές στον \(\mathbb{R}^{s}\) και \(\mathbf{E}||X||^{2}< +\infty\), τότε ορίζουμε ως (σταυρωτή) συνδιακύμανση των τ.δ. \(X\) και \(Y\), τον πίνακα \[\begin{equation*} \Sigma_{X,Y} \equiv \mathbf{C}(X,Y) := \begin{pmatrix} \text{Cov}(X_1,Y_1) & \text{Cov}(X_1,Y_2) & \ldots & \text{Cov}(X_1,Y_s) \\ \text{Cov}(X_2,Y_1) & \text{Cov}(X_2,Y_2) & \ldots & \text{Cov}(X_2,Y_s) \\ \vdots & \vdots & \ddots & \vdots \\ \text{Cov}(X_d,Y_1) & \text{Cov}(X_d,Y_2) & \ldots & \text{Cov}(X_d,Y_s). \end{pmatrix} \end{equation*}\] Τα τ.δ. \(X\) και \(Y\) λέγονται , αν o \(C(X,Y)\) είναι ο μηδενικός πίνακας.

Παρατήρηση:. Από τους παραπάνω ορισμούς είναι φανερό ότι \(\mathbf{C}(X,X)=\mathbf{V}(X)\) και \(\mathbf{C}(Y,X)=\mathbf{C}(X,Y)^{\top}\). Παρατηρούμε λοιπόν εδώ ότι ο πίνακας συνδιακύμανσης μεταξύ δύο τ.δ. (έτσι όπως τον ορίσαμε) δεν είναι γενικά συμμετρικός, εκτός αν \(X=Y\), οπότε ταυτίζεται με τον συμμετρικό πίνακα \(\mathbf{V}(X)\).

Στην επόμενη πρόταση δίνουμε κάποιες στοιχειώδεις ιδιότητες της μέσης τιμής τυχαίων διανυσμάτων.

Πρόταση 1.5 Έστω \(X,Y\) τυχαία διανύσματα με τιμές στον \(\mathbb{R}^{d}\) με \(\mathbf{E}||X||, \mathbf{E}||Y||< +\infty\) και \(A, \, b\) πίνακας και διάνυσμα κατάλληλης διάστασης. Τότε ισχύουν τα εξής:

\[\begin{eqnarray*} \mathbf{E}(AX + b) & = & A \mathbf{E}(X) + b, \\ \mathbf{E}(X+Y) & = & \mathbf{E}(X) + \mathbf{E}(Y). \end{eqnarray*}\]

Στην επόμενη πρόταση δίνουμε στοιχειώδεις ιδιότητες της διασποράς τυχαίων διανυσμάτων.

Πρόταση 1.6 Έστω \(X,Y\in\mathbb{R}^{d}\) τυχαία διανύσματα με \(\mathbf{E}||X||^{2}, \mathbf{E}||Y||^{2}< +\infty\) και \(A, \, b\) πίνακας και διάνυσμα κατάλληλης διάστασης. Τότε ισχύουν τα εξής:

\[\begin{eqnarray*} \mathbf{V}(X) & = & \mathbf{E}\left((X-\mu_X)(X-\mu_X)^{\top}\right) = \mathbf{E}(X X^{\top}) - \mathbf{E}(X)\mathbf{E}(X^{\top}),\\ \mathbf{V}(AX + b) & = & A \mathbf{V}(X)\, A^{\top}, \\ \mathbf{V}(X+Y) & = & \mathbf{V}(X) +\mathbf{V}(Y) + \mathbf{C}(X,Y) + \mathbf{C}(Y,X). \end{eqnarray*}\]

Ακολουθούν ιδιότητες που συνδέονται με τη συνδιακύμανση δύο τυχαίων διανυσμάτων.

Πρόταση 1.7 Έστω \(X,\,Y\) τυχαία διανύσματα με τιμές στον \(\mathbb{R}^{d}\) και \(\mathbb{R}^{s}\) αντίστοιχα. Αν υποθέσουμε ότι \(\mathbf{E}||X||^{2},\mathbf{E}||Y||^{2}< +\infty\), τότε ισχύουν τα εξής:

\[\begin{eqnarray*} \mathbf{C}(X, Y) & = & \mathbf{E}\left((X-\mu_X)(Y-\mu_Y)^{\top}\right) = \mathbf{E}(X Y^{\top}) - \mathbf{E}(X)\mathbf{E}(Y^{\top}), \\ \mathbf{C}(AX + b, BY + c ) & = & A \mathbf{C}(X,Y)\, B^{\top}. \end{eqnarray*}\]

1.2.3 Σύγκλιση κατά κατανομή

Η σύγκλιση κατά κατανομή για ακολουθίες τυχαίες διανυσμάτων δε μπορεί να αναχθεί σε σύγκλιση κατά κατανομή των συνιστωσών ακολουθιών τυχαίων μεταβλητών, καθώς είναι σημαντικό να ληφθεί υπόψη η εξάρτησή τους. Παρουσιάζει λοιπόν μεγαλύτερο ενδιαφέρον η μελέτη αυτής της σύγκλισης και έχουν δοθεί αρκετοί ισοδύναμοι χαρακτηρισμοί που είναι βολικοί κατά περίπτωση. Δίνουμε τώρα μερικούς από αυτούς σε αντιστοιχία με την πρόταση 1.4.

Θεώρημα 1.6 Μία ακολουθία τ.δ. \((X_n)\) συγκλίνει κατά κατανομή σε ένα τ.δ. \(X\in \mathbb{R}^{d}\), αν και μόνο αν,

για κάθε σημείο συνεχείας \(x\in \mathbb{R}^{d}\) της \(F\) \[\begin{equation*} F_n(x) \xrightarrow[n\rightarrow \infty]{} F(x), \end{equation*}\] όπου \(F_n,F\) είναι οι σ.κ. των \(X_n,X\),

(τέχνασμα Cramér–Wold) κάθε γραμμικός συνδιασμός των συνιστωσών της \(X_n\) συγκλίνει κατά κατανομή στον αντίστοιχο γραμμικό συνδιασμό των συνιστωσών της \(X\), δηλαδή, για κάθε \(u\in \mathbb{R}^{d}\) \[\begin{equation*} u^{\top}X_n \xrightarrow[]{d} u^{\top}X, \end{equation*}\]

για κάθε \(f:\mathbb{R}^{d}\rightarrow \mathbb{R}\) συνεχή και φραγμένη συνάρτηση

\[\begin{equation*} \mathbf{E}[f(X_n)] \xrightarrow[n\rightarrow \infty]{} \mathbf{E}[f(X)]. \end{equation*}\]

1.2.4 Πολυδιάστατη Κανονική Κατανομή

Η πιο σημαντική συνεχής πολυδιάστατη κατανομή είναι η κανονική κατανομή για τους ίδιους λόγους που είναι και στη μονοδιάστατη περίπτωση. Θα στηρίξουμε τον επόμενο ορισμό της κανονικής κατανομής στην Πρόταση 1.4–(2), χρησιμοποιώντας τις κατανομές όλων των γραμμικών συνδιασμών των συνιστωσών ενός τ.δ..

Ορισμός 1.13 Έστω \(X=(X_1,X_2,\ldots,X_d)\) ένα τ.δ. με \(d\geq 1\), \(\mu \in \mathbb{R}^{d}\) ένα διάνυσμα και \(\Sigma\) ένας συμμετρικός και θετικά ημιορισμένος πίνακας. Θα λέμε ότι το \(X\) ακολουθεί την κανονική κατανομή \(\mathcal{N}_{d}(\mu, \Sigma)\) με παραμέτρους \(\mu\) και \(\Sigma\), αν για κάθε \(u \in \mathbb{R}^{d}\)

\[\begin{equation} u^{\top}X \sim \mathcal{N}_{1}(u^{\top} \mu, \, u^{\top}\Sigma \, u). \end{equation}\]

Αν ο \(\Sigma\) είναι θετικά ορισμένος (και όχι απλά ημιορισμένος), τότε αν θέλουμε να το δηλώσουμε ξεκάθαρα θα γράφουμε ότι \(X\sim \mathcal{Ν}_{d}^{*}(\mu, \Sigma)\).

Ας μελετήσουμε γραφικά τη διδιάστατη κανονική \(\mathcal{N}_2(0, \Sigma)\), με πίνακα διασπορών - συνδιασπορών

\[\begin{equation*} \Sigma = \left( \begin{array}{cc} 1 & p \\ p & 1 \end{array} \right), \end{equation*}\]

για τις διάφορες τιμές της παραμέτρου \(p\).

Πρόταση 1.8 Αν ένα τ.δ. \(X\sim \mathcal{N}_d(\mu, \, \Sigma)\), τότε \(\mathbf{E}(X)=\mu\) και \(\mathbf{V}(X)=\Sigma\).

Απόδειξη:. Από τον ορισμό 1.13 για \(u=e_i\), \(i=1,\ldots,d\), έχουμε

\[\begin{equation*} X_i = e_i^{\top}X \sim \mathcal{N}_{1}\left(e_i^{\top} \mu, \, e_i^{\top}\Sigma \, e_i\right) = \mathcal{N}_{1}(\mu_i, \, \Sigma_{ii}), \end{equation*}\]

από το οποίο συμπεραίνουμε ότι \(\mathbf{E}(X_i)=\mu_i\) και \(\mathbf{V}(X_i)=\Sigma_{ii}\). Από τις συνιστώσες μέσες τιμές συμπεραίνουμε ότι \(\mathbf{E}(X)=\mu\) και από τις διασπορές ότι τα διαγώνια στοιχεία του \(\Sigma\) συμπίπτουν με αυτές. Θέτοντας τώρα \(u=e_i+e_j\), \(i,j=1,\ldots,d\), \(i\neq j\) έχουμε

\[\begin{equation*} \mathbf{V}(X_i+X_j)= \mathbf{V}[(e_i+e_j)^{\top}X] = (e_{i}^{\top}+e_j^{\top})\, \Sigma \, (e_{i}+e_j)=\Sigma_{ii}+\Sigma_{jj}+2\Sigma_{ij}. \end{equation*}\]

Από τη σχέση

\[\begin{equation*} \mathbf{V}(X_i+X_j)= \mathbf{V}(X_i) + \mathbf{V}(X_j) + 2\,\text{Cov}(X_i,X_j), \end{equation*}\]

και τα παραπάνω καταλήγουμε στο ότι \(\text{Cov}(X_i,X_j)=\Sigma_{ij}\) και έτσι φτάνουμε στο ζητούμενο και για τον πίνακα διασποράς.

Παρατήρηση:. Γίνεται σαφές από την παραπάνω απόδειξη ότι αν για ένα οποιοδήποτε τ.δ. \(X\) ισχύει ότι για κάθε \(u\in \mathbb{R}^{d}\), η μέση τιμή \(\mathbf{E}(u^{\top}X)=u^{\top}\mu\) και η διασπορά \(\mathbf{V}(u^{\top}X)=u^{\top}\,\Sigma \, u\), τότε \(\mathbf{E}(X)=\mu\) και \(\mathbf{V}(X)=\Sigma\).

Η πιο απλή περίπτωση πολυδιάστατης κανονικής είναι βέβαια ένα τ.δ. \(Z\) που αποτελείται από ανεξάρτητες τ.μ. που ακολουθούν την τυπική κανονική.

Πόρισμα 1.3 Αν \(Z\sim \mathcal{N}_d(0_d,I_d)\), όπου \(0_d\) είναι το μηδενικό διάνυσμα και \(I_d\) είναι ο ταυτοτικός πίνακας \(d\)-τάξης, τότε οι συνιστώσες του \(Ζ\) είναι ανεξάρτητες και ισόνομες τ.μ. που ακολουθούν την τυπική κανονική. Λέμε ότι το \(Z\) ακολουθεί την τυπική κανονική διάστασης \(d\).

Απόδειξη:. Ας υποθέσουμε ότι \(Z\sim \mathcal{N}_d(0_d,I_d)\). Τότε από τον ορισμό της πολυδιάστατης κανονικής έχουμε \(u^{\top}Z \sim \mathcal{N}_1(0,u^{\top}u)\). Ας υποθέσουμε τώρα ότι παίρνουμε ένα τ.δ. \(W=(W_{1},\ldots,W_{d})\) που αποτελείται από τ.μ. \(W_{i}\) ανεξάρτητες τυπικές κανονικές. Τότε \(u^{\top}W \sim \mathcal{N}_1(0,u^{\top}u)\), από γνωστό αποτέλεσμα για γραμμικούς συνδιασμούς ανεξάρτητων τ.μ. που ακολουθούν κανονική κατανομή. Καταλήγουμε στο συμπέρασμα ότι \(u^{\top}Z \stackrel{d}{=} u^{\top}W\) για κάθε \(u\in \mathbb{R}^{d}\) και άρα \(Ζ\stackrel{d}{=} W\).

Στην επόμενη πρόταση δίνονται κάποιες σημαντικές ιδιότητες της πολυδιάστατης κανονικής κατανομής.

Πρόταση 1.9 Έστω \(X\sim \mathcal{N}_d(\mu,\Sigma)\), με μέση τιμή \(\mu \in \mathbb{R}^d\) και πίνακα διασποράς \(\Sigma\).

- Αν \(Α\in \mathbb{R}^{s\times d}\) και \(b\in \mathbb{R}^{s}\), τότε

\[\begin{equation} AX + b \sim \mathcal{N}_s\left(A\mu + b,\, A\,\Sigma \, A^{\top}\right) \tag{1.1} \end{equation}\]

- Aν ο \(\Sigma\) είναι θετικά ορισμένος (αντιστρέψιμος), τότε το τ.δ. \(X\) έχει συνάρτηση πυκνότητας πιθανότητας στον \(\mathbb{R}^d\) της μορφής

\[\begin{equation} f_{X}(x) = (2\pi)^{-d/2}\left(\det\,(\Sigma)\right)^{-1/2} \exp\left\{-\,\frac{1}{2}(x-\mu)^{\top}\,\Sigma^{-1}(x-\mu) \right\} \quad \forall x\in \mathbb{R}^{d}. \tag{1.2} \end{equation}\]

Απόδειξη:.

Έστω \(u\in \mathbb{R}^{s}\). Tότε, \[\begin{equation*} u^{\top}(AX + b) = (u^{\top}A)X + u^{\top}b = (A^{\top}u)^{\top}X + u^{\top}b \sim \mathcal{N}_1\left(\,(A^{\top}u)^{\top}\mu,\, (A^{\top}u)^{\top}\,\Sigma \, A^{\top}u\right) + u^{\top}b, \end{equation*}\] όπου η τελευταία σχέση έπεται από την υπόθεση ότι \(X\sim \mathcal{N}_d(\mu,\Sigma)\) και άρα \(v^{\top}X \sim \mathcal{N}_1\left(v^{\top}\mu,v^{\top} \Sigma v\right)\) για \(v=A^{\top}u \in \mathbb{R}^{d}\). Τελικά, η παραπάνω σχέση ξαναγράφεται στη μορφή \[\begin{equation*} u^{\top}(AX + b) \sim \mathcal{N}_1\left(\,u^{\top}(Α\mu+b),\, u^{\top}A\Sigma \, A^{\top}u\right), \end{equation*}\] από την οποία συμπεραίνουμε την (1.1).

Aν ο \(\Sigma\) είναι θετικά ορισμένος, τότε γράφεται στη μορφή \(\Sigma = AA^{\top}\), με \(Α\) αντιστρέψιμο. Ο πίνακας \(Α\) παίζει το ρόλο μιας τετραγωνικής ρίζας του \(\Sigma\). Συμπεραίνουμε λοιπόν από το ερώτημα (1) ότι το τ.δ. \[\begin{equation*} Z = A^{-1}(X-\mu) \sim \mathcal{N}_d\left(0_d,\, A^{-1}\,\Sigma \, (A^{-1})^{\top}\right) \end{equation*}\] και επειδή \(A^{-1}\,\Sigma \, (A^{-1})^{\top}=A^{-1}AA^{\top}(A^{-1})^{\top}=I_d\), καταλήγουμε στο ότι \(Ζ\sim \mathcal{N}_d(0_d,I_d)\). Η σ.π.π. του \(Ζ\) είναι \[\begin{equation*} f_{Z}(z) = \prod_{i=1}^{d}f_{Z_i}(z_i)=\prod_{i=1}^{d}(2\pi)^{-1/2}e^{-z_i^2/2}=(2\pi)^{-d/2} \exp\left\{-\,\frac{1}{2}z^{\top}z \right\} \quad \forall z\in \mathbb{R}^{d}. \end{equation*}\] Συμπεραίνουμε ότι το τ.δ. \(X=AZ + \mu\) έχει σ.π.π. στον \(\mathbb{R}^d\) της μορφής \[\begin{equation*} f_{X}(x) = (2\pi)^{-d/2}\vert \det\,(A)\vert^{-1} \exp\left\{-\,\frac{1}{2}\left(A^{-1}(x-\mu)\right)^{\top}\left(A^{-1}(x-\mu)\right) \right\}. \end{equation*}\] Η παραπάνω έκφραση συμπίπτει με την (1.2).

1.2.5 Πολυδιάστατο Κεντρικό Οριακό Θεώρημα

Είμαστε τώρα σε θέση να παρουσιάσουμε το πολυδιάστατο Κεντρικό Οριακό Θεώρημα σε δύο ισοδύναμες μορφές.

Πρόταση 1.10 Έστω \((X_n)\) μία ακολουθία ανεξάρτητων και ισόνομων τ.δ. με \(\mathbf{E} \lVert X_1 \rVert ^{2}< +\infty\). Θέτουμε \(\mu_X=\mathbf{E}(X)\) και \(\Sigma_{X}=\mathbf{V}(X)\). Αν \(\left(\overline{X}_n\right)\) είναι η ακολουθία των δειγματικών μέσων και \((S_n)\) η ακολουθία των μερικών αθροισμάτων της \((X_n)\), τότε

\[\begin{equation*} \sqrt{n}\left(\,\overline{X}_n-\mu_X\right) \xrightarrow[]{d} \mathcal{N}_{d}\,(0_{d}, \, \Sigma_{X}), \end{equation*}\]

και

\[\begin{equation*} \frac{S_n- n\,\mu_X}{\sqrt{n}} \xrightarrow[]{d} \mathcal{N}_{d}\,(0_{d}, \, \Sigma_{X}). \end{equation*}\]

Απόδειξη:. Θα αποδείξουμε την πρώτη από τις δύο ισοδύναμες μορφές. Η δεύτερη έπεται από την παρατήρηση ότι \(S_n = n \overline{X}_n\). Έστω λοιπόν \(U\) ένα τ.δ. με \(U\sim \mathcal{N}_{d} (0_{d}, \Sigma_{X})\) και \(u\in \mathbb{R}^{d}\). Από το Θεώρημα 1.6 αρκεί να δείξουμε ότι

\[\begin{equation} u^{\top}\left\{\sqrt{n}\left(\overline{X}_n-\mu_X\right)\right\} \xrightarrow[]{d} u^{\top} U \sim \mathcal{N}_{1}(0, u^{\top}\Sigma_{X}u). \tag{1.3} \end{equation}\]

Παρατηρούμε όμως ότι

\[\begin{equation*} u^{\top}\left\{\sqrt{n}\left(\,\overline{X}_n-\mu_X\right)\right\} = \sqrt{n}\left(\overline{u^{\top}X_n}-u^{\top}\mu_X\right) = \sqrt{n}\left(\overline{Y}_n-\mu_Y\right), \end{equation*}\]

όπου \((Y_n)\) είναι ακολουθία ανεξάρτητων και ισόνομων τ.μ. με \(Y_n=u^{\top}X_n\) και \(\mu_Y = \mathbf{E}(Y_1) = u^{\top}\mu_X\). Από το κλασσικό Κεντρικό Οριακό Θεώρημα έχουμε

\[\begin{equation*} \sqrt{n}\left(\overline{Y}_n-\mu_Y\right) \xrightarrow[]{d} \mathcal{N}_{1}(0, \mathbf{V}(Y_1)) = \mathcal{N}_{1}(0, u^{\top}\Sigma_{X}u ), \end{equation*}\]

που είναι η οριακή κατανομή (1.3) που θέλαμε να φτάσουμε.

Ας μελετήσουμε μία εφαρμογή που συνδιάζει το πολυδιάστατο ΚΟΘ με το λήμμα του Slutsky.

Παράδειγμα 1.2 Έστω \((X_n)\) ακολουθία α.ι.τ.μ. με \(\mathbb{E}(X_1^4)<+\infty\), όπου τα \(\mu=\mathbb{E}(X_1)\) και \(\sigma^2=\textbf{V}(X_1)\) είναι άγνωστα. Θέτουμε \(\widehat{\theta}_n=\left(\widehat{\mu}_n,\, \widehat{\sigma_n^2} \right)^{\top} = \left( \overline{X}_n,\, M_n\right)^{\top}\), όπου \(\overline{X}_n\) και \(M_n=\dfrac{1}{n}\sum\limits_{i=1}^{n}(X_i-\overline{X}_n)^2\) είναι οι εκτιμήτριες ροπών. Σε τυχαίο δείγμα από την κανονική κατανομή \(N(\mu, \sigma^2)\) οι \(\widehat{\mu}_n\) και \(\widehat{\sigma_n^2}\) είναι ανεξάρτητες, γενικά όμως όχι. Αναζητούμε την ασυμπτωτική κατανομή του \(\sqrt{n}\left(\widehat{\theta}_n-\theta\right)\). Θέτουμε \(N_n=\dfrac{1}{n}\sum\limits_{i=1}^{n}(X_i-\mu)^2\), και τότε

\[\begin{equation*} M_n-N_n=\dfrac{1}{n}\sum\limits_{i=1}^{n}\Big[ (X_i-\overline{X}_n)^2 - (X_i-\mu)^2\Big] = -\, (\overline{X}_n-\mu)^2 \end{equation*}\]

\[\begin{align*} \sqrt{n}\left(\hat{\theta}_n-\theta\right) &= \sqrt{n}\left[ \begin{pmatrix} \overline{X}_n \\ M_n \end{pmatrix} - \begin{pmatrix} \mu \\ \sigma^2 \end{pmatrix} \right] \\ &= \sqrt{n}\left[ \begin{pmatrix} \overline{X}_n \\ N_n \end{pmatrix} - \begin{pmatrix} \mu \\ \sigma^2 \end{pmatrix} \right] - \sqrt{n} \begin{pmatrix} 0 \\ (\overline{X}_n-\mu)^2 \end{pmatrix}. \end{align*}\]

Έχουμε ότι \(\sqrt{n}(\overline{X}_n-\mu)\xrightarrow{d} \mathcal{N}(0, \sigma^2)\) και \(\overline{X}_n-\mu\xrightarrow{p} 0\). Από το μονοδιάστατο Slutsky έχουμε

\[\begin{equation*} \sqrt{n}(\overline{X}_n-\mu)^2 = (\overline{X}_n-\mu)\cdot \sqrt{n}\,(\overline{X}_n-\mu) \xrightarrow{d} 0 \cdot \mathcal{N}(0, \sigma^2)=0, \end{equation*}\]

και άρα συμπεραίνουμε ότι

\[\begin{equation*} \begin{pmatrix} 0 \\ -\sqrt{n}(\overline{X}_n-\mu)^2 \end{pmatrix} \xrightarrow{p} \begin{pmatrix} 0 \\ 0 \end{pmatrix}. \end{equation*}\]

Από τα παραπάνω, το αρχικό πρόβλημα ανάγεται στην εύρεση της οριακής κατανομής της \(\sqrt{n}\left[ (\overline{X}_n \ \ N_n)^{\top} - (\mu \ \ \sigma^2)^{\top} \right]\). Παρατηρούμε τώρα ότι

\[\begin{equation*} N_n=\dfrac{1}{n}\sum\limits_{i=1}^{n}(X_i-\mu)^2=:\overline{(X-\mu)^{2}_{[n]}}, \end{equation*}\]

άρα

\[\begin{equation*} \sqrt{n}\left[ \begin{pmatrix} \overline{X}_n \\ \\ \overline{(X-\mu)^{2}_{[n]}} \end{pmatrix} - \begin{pmatrix} \mu \\ \\ \sigma^2 \end{pmatrix} \right]=\sqrt{n}\,\Big(\overline{Y_n}-\mathbf{E}(Y_1)\Big), \end{equation*}\]

όπου \(Y_n=\begin{pmatrix} X_n \\ (X_n-\mu)^2 \end{pmatrix}=g(X_n)\) για \(g(x)=(x,\ (x-\mu)^2)^{\top}\) και οι \(g(X_n)\) είναι α.ι.τ.δ. (διότι οι \(X_n\) είναι α.ι.τ.μ.), με

\[\begin{equation*} \mathbf{E}(Y_n)=\mathbf{E}(Y_1)=\begin{pmatrix} \mathbf{E}(X_1) \\ \mathbf{E}(X_1-\mu)^2 \end{pmatrix}=\begin{pmatrix} \mu \\ \sigma^2 \end{pmatrix}. \end{equation*}\]

Προφανώς, ο πίνακας διασπορών-συνδιασπορών \(\Sigma\) υπάρχει και

\[\begin{equation*} \Sigma:=\textbf{V}(Y_1)=\begin{pmatrix} \textbf{V}(X_1) & \textbf{C}\big(X_1, (X_1-\mu)^2\big) \\ \textbf{C}\big(X_1, (X_1-\mu)^2\big) & \textbf{V}\big((X_1-\mu)^2\big) \end{pmatrix}. \end{equation*}\]

Υπολογίζουμε τα στοιχεία του πίνακα:

- \(\mathbf{C}\big(X_1, (X_1-\mu)^2\big)= \mathbf{C}\big(X_1-\mu, (X_1-\mu)^2 \big)= \underbrace{ \mathbf{E}\big((X_1-\mu)^3 \big)}_{\mu_3}-\underbrace{ \mathbf{E}(X_1-\mu)}_{0}\mathbf{E}(X_1-\mu)^2=\mu_3\)

- \(\mathbf{V}\big( (X_1-\mu)^2 \big)=\mathbf{E}(X_1-\mu)^4-\mathbf{E}^2(X_1-\mu)^2=\mu_4-\sigma^4\).

Από τα παραπάνω συμπεραίνουμε ότι

\[\begin{equation*} \Sigma=\begin{pmatrix} \sigma^2 & \mu_3 \\ \mu_3 & \mu_4-\sigma^4 \end{pmatrix}. \end{equation*}\]

Είναι χρήσιμο πολλές φορές να χρησιμοποιούνται ως παράμετροι μίας κατανομής ο συντελεστής λοξότητας \(\lambda=\mathbf{E}\left(\frac{X-\mu}{\sigma}\right)^3\) και ο συντελεστής κύρτωσης \(\kappa=\mathbf{E}\left(\frac{X-\mu}{\sigma}\right)^4\). Έτσι, ο πίνακας \(\Sigma\) μπορεί να γραφεί στη μορφή

\[\begin{equation*} \Sigma=\begin{pmatrix} \sigma^2 & \lambda \sigma^3 \\ \lambda \sigma^3 & (\kappa-1)\sigma^4 \end{pmatrix}. \end{equation*}\]

Με εφαρμογή του πολυδιάστατου Κεντρικού Οριακού Θεωρήματος για την ακολουθία των α.ι.τ.δ. \((Y_n)\) και λόγω των παραπάνω σχέσεων, έχουμε τελικά ότι

\[\begin{equation*} \sqrt{n}\left(\hat{\theta}_n-\theta\right) \xrightarrow{d} \mathcal{N}_2(0, \Sigma), \end{equation*}\]

ή γραμμένο αναλυτικά,

\[\begin{equation*} \sqrt{n}\left[ \left(\widehat{\mu}_n, \widehat{\sigma^2}_{n}\right)^\top - \left( \mu, \sigma^2\right)^\top \right] \xrightarrow{d} \mathcal{N}_2(0, \Sigma). \end{equation*}\]

Εφαρμόζοντας μέθοδο Δέλτα για την συνάρτηση \(\phi(x,y)=(x, \sqrt{y})\) με Ιακωβιανό πίνακα \(\Phi'=\left[\begin{array}{cc} 1 & 0 \\ 0 & \frac{1}{2\sigma} \end{array} \right]\), και λαμβάνοντας υπ’ όψιν το αναλλοίωτο της ε.μ.π., μπορούμε να έχουμε το αντίστοιχο αποτέλεσμα για την τυπική απόκλιση

\[\begin{equation*} \sqrt{n}\left(\phi\left(\hat{\theta}_n\right)-\phi\left(\theta\right)\right) \xrightarrow{d} \mathcal{N}_2\left(0, \Phi'\Sigma\Phi'^\top\right), \end{equation*}\]

ή γραμμένο αναλυτικά,

\[\begin{equation*} \sqrt{n}\left[ \left(\widehat{\mu}_n, \widehat{\sigma}_{n}\right)^\top - \left( \mu, \sigma\right)^\top \right] \xrightarrow{d} \mathcal{N}_2(0, \Sigma'), \tag{1.4} \end{equation*}\]

όπου

\[\begin{equation*} \Sigma'=\sigma^2\begin{pmatrix} 1 & \lambda/2 \\ \lambda/2 & (\kappa-1)/4 \end{pmatrix}. \end{equation*}\]

Από τα παραπάνω εξάγουμε άμεσα και τις περιθώριες οριακές κατανομές των \(\widehat{\sigma^2}_n\) και \(\widehat{\sigma}_n\):

\[\begin{equation*} \sqrt{n}\left(\widehat{\sigma^2}_n-\sigma^2\right)\overset{d}{\longrightarrow}\mathcal{N}\left(0, (\kappa-1)\sigma^4\right). \end{equation*}\]

\[\begin{equation*} \sqrt{n}\left(\widehat{\sigma}_n-\sigma\right)\overset{d}{\longrightarrow}\mathcal{N}\left(0, \frac{\kappa-1}{4}\sigma^2\right). \end{equation*}\]

1.2.6 Πολυωνυμική Κατανομή

Η πολυωνυμική κατανομή γενικεύει τη διωνυμική κατανομή. Είναι γνωστό ότι μία τ.μ. που ακολουθεί τη διωνυμική κατανομή ερμηνεύεται ως το πλήθος των επιτυχιών σε ένα δεδομένο αριθμό ανεξάρτητων δοκιμών Bernoulli με σταθερή πιθανότητα επιτυχίας σε κάθε δοκιμή. Αν η επιτυχία δεν είναι μονοσήμαντα ορισμένη, αλλά θεωρήσουμε για παράδειγμα ότι υπάρχουν \(d\) είδη επιτυχιών, τότε είναι φυσιολογικό να αναζητήσουμε την κατανομή της δ.τ.μ. που εκφράζει την από κοινού καταγραφή του πλήθους των επιτυχιών \(i-\)είδους σε ένα δεδομένο αριθμό ανεξάρτητων δοκιμών, όπου σε κάθε δοκιμή έχουμε το πολύ μία επιτυχία \(i-\)είδους με σταθερή πιθανότητα. Για παράδειγμα, σε \(20\) ρίψεις ενός ζαριού μπορεί κάποιος να ενδιαφέρεται για την απο κοινού κατανομή του πλήθους των ρίψεων που ήρθαν \(1\) μαζί με αυτές που ήρθαν \(6\). Εδώ, σε κάθε ρίψη μπορούμε να θεωρήσουμε την ένδειξη \(1\) ως επιτυχία πρώτου είδους και την ένδειξη \(6\) ως επιτυχία δεύτερου είδους. Αν το ζάρι είναι δίκαιο τότε και τα δύο είδη επιτυχιών έχουν σταθερή πιθανότητα \(1/6\) σε κάθε δοκιμή. Αν στο ίδιο τυχαίο πείραμα σε κάθε δοκιμή αντιστοιχίσουμε την αποτυχία, δηλαδή την εμφάνιση κάποιας από τις έδρες \(2\), \(3\), \(4\) ή \(5\), σε επιτυχία τρίτου είδους και συμπεριλάβουμε την τ.μ. που καταγράφει το πλήθος των επιτυχιών τρίτου είδους στις δύο προηγούμενες, τότε είναι φανερό ότι δεν κερδίζουμε παραπάνω πληροφορία αφού η τελευταία καθορίζεται πλήρως ως η διαφορά του πλήθους των συνολικών δοκιμών από το άθροισμα των επιτυχιών πρώτου και δεύτερου είδους. Παρ όλα αυτά συναντάμε στη βιβλιογραφία και τις δύο αυτές ισοδύναμες μορφές της πολυωνυμικής κατανομής. Πριν δώσουμε τον τυπικό ορισμό τους, ας δούμε μία χρήσιμη επέκταση του διωνυμικού συντελεστή.

Υπενθυμίζουμε ότι ο διωνυμικός συντελεστής \(\binom{n}{k}\) φέρει το όνομα αυτό λόγω του ότι προκύπτει ως συντελεστής στο διωνυμικό ανάπτυγμα. Συγκεκριμένα,

\[\begin{equation*} (x+y)^n = \sum_{k=0}^{n}\,\binom{n}{k}\,x^{k}y^{n-k}, \quad \textrm{όπου}\ \ \binom{n}{k}=\frac{n!}{k!(n-k)!}. \end{equation*}\]

Εύκολα δείχνεται (με επαγωγή στο \(n\)) η ισχύς του πολυωνυμικού θεωρήματος, το οποίο μας επιτρέπει να γενικεύσουμε το διωνυμικό ανάπτυγμα από πολυώνυμα \(2\) μεταβλητών σε πολυώνυμα \(d\) μεταβλητών:

\[\begin{equation} (x_1+x_2+\ldots + x_d)^n = \sum_{k=0}^{n}\,\frac{n!}{n_1!n_2!\ldots n_d!}\,x_1^{n_1}x_2^{n_2}\ldots x_d^{n_d}, \quad \textrm{όπου} \ \ n_1+n_2+\ldots n_d =n. \tag{1.5} \end{equation}\]

Αν κάνουμε μία αρίθμηση (διάκριση) των \(n\) παραγόντων που εμφανίζονται στο αριστερό μέλος:

\[\begin{equation*} \underbrace{(x_1+x_2+\ldots + x_d)}_{1}\cdot\underbrace{(x_1+x_2+\ldots + x_d)}_{2}\cdot\ldots \cdot\underbrace{(x_1+x_2+\ldots + x_d)}_{n}, \end{equation*}\]

τότε είναι φανερό ότι το ανάπτυγμα συνίσταται σε ένα άθροισμα διακεκριμένων μονωνύμων βαθμού \(n\) (επιλέγοντας μία μεταβλητή από κάθε παράγοντα) της μορφής \(x_1^{n_1}x_2^{n_2}\ldots x_d^{n_d}\), όπου κάθε εκθέτης αντιστοιχεί στο πλήθος των φορών που επιλέχθηκε η αντίστοιχη μεταβλητή, και σε κάθε μονώνυμο αντιστοιχεί ένας συντελεστής που εκφράζει το πλήθος των διαφορετικών τρόπων με τους οποίους μπορούμε να επιλέξουμε μέσα από το σύνολο των \(n\) διακεκριμένων παραγόντων (θέσεων), τις \(n_1\) θέσεις για την επιλογή του \(x_1\), τις \(n_2\) θέσεις για την επιλογή του \(x_2\) και τις υπολοιπόμενες \(n_d\) θέσεις για την επιλογή του \(x_d\). Η σκέψη αυτή μας οδηγεί σε μία δεύτερη συνδιαστική απόδειξη (χωρίς επαγωγή) του πολυωνυμικού αναπτύγματος (1.5) κάνοντας χρήση της πολλαπλασιαστικής αρχής (ολοκληρώστε την απόδειξη).

Ορισμός 1.14 Έστω \(n, n_i \in \mathbb{N}\), \(i=1,2,\ldots,d\) με \(n_1+n_2+\ldots n_{d}=n\). Λέμε πολυωνυμικό συντελεστή τον αριθμό

\[\begin{equation}\label{multi-coeff-1} \binom{n}{n_1,n_2,\ldots,n_d}:=\frac{n!}{n_1!n_2!\ldots n_d!}, \end{equation}\]

που εμφανίζεται ως συντελεστής στο πολυωνυμικό ανάπτυγμα (1.5).

Παρατήρηση:.

Στην ειδική περίπτωση που \(d=2\), ο πολυωνυμικός συντελεστής αντιστοιχεί στο διωνυμικό συντελεστή, έτσι έχουμε \(\binom{n}{k,n-k}=\binom{n}{k}\). Παραδοσιακά προτιμάται ο τελευταίος συμβολισμός που είναι και ο πιο σύντομος.

Κάποιες φορές ο πολυωνυμικός συντελεστής εμφανίζεται στη μορφή \[\begin{equation}\label{multi-coeff-4} \binom{n}{n_1,n_2,\ldots,n_{d-1}}:=\frac{n!}{n_1!\ldots n_{d-1}! (n-n_1-\ldots-n_{d-1})!}. \end{equation}\] Αυτό δεν θα πρέπει να προκαλεί σύγχυση αφού οι 2 εκφράσεις διακρίνονται από το αν οι δείκτες που εκφράζουν το πλήθος των επιλογών αθροίζουν ή όχι στο συνολικό πλήθος των στοιχείων \(n\).

Είναι φανερό από τα σχόλια που ακολουθούν το πολυωνυμικό ανάπτυγμα ότι ο πολυωνυμικός συντελεστής εκφράζει το πλήθος των διαφορετικών τρόπων με τους οποίους μπορούμε να διαμερίσουμε ένα σύνολο \(n\) στοιχείων σε \(d\) υποσύνολα με \(n_i\) στοιχεία το καθένα, \(1\leq i \leq d\).

Είμαστε τώρα σε θέση να ορίσουμε την πολυωνυμική κατανομή που αντιπροσωπεύει την κατανομή ενός τυχαίου διανύσματος που καταγράφει το πλήθος των επιτυχιών όλων των ειδών σε \(n\) ανεξάρτητες δοκιμές με σταθερές πιθανότητες επιτυχίας κάθε είδους σε κάθε δοκιμή, όταν σε κάθε μία από αυτές έχουμε επιτυχία μόνο ενός είδους ή το πολύ ενός. Για να αποφύγουμε ενδεχόμενη σύγχυση θα διακρίνουμε αυτές τις δύο ισοδύναμες μορφές, οι οποίες διαφέρουν μόνο στο αν θα ονομάσουμε την αποτυχία ως επιτυχία ενός επιπρόσθετου είδους με ταυτόχρονη καταγραφή του πλήθους τους ή απλά θα τις εξαιρέσουμε από την ανάλυσή μας. Πρακτικά, αυτό φαίνεται από το αν τα σημεία που έχουν θετική πιθανότητα έχουν σταθερό άθροισμα ή όχι αντίστοιχα.

Ορισμός 1.15 Έστω \(X=(X_1,\ldots,X_d)\) ένα τ.δ. με \(d\geq 2\). Θα λέμε ότι το \(X\) ακολουθεί την πολυωνυμική κατανομή \(\mathcal{M}(n,p_1,\ldots,p_d)\) με παραμέτρους \(n\geq 1\) και \(p_1,\ldots,p_d > 0\), όπου \(\sum_{i=1}^{d}{p_i}=1\), αν

\[\begin{equation}\label{multi-coeff-5} \mathbf{P}(X_1=x_1,\ldots,X_d=x_d) = \binom{n}{x_1,\ldots,x_d}p_{1}^{x_1}\ldots p_{d}^{x_d}, \ \ \textrm{όπου} \ x_i\in \mathbb{N}, \ 1\leq i \leq d,\ \textrm{και} \ \sum_{i=1}^{d}{x_i}=n. \end{equation}\]

Αν όμως \(d\geq 1\) και \(S_{X}=\left\{x\in \mathbb{N}^{d} : 0 \leq \sum_{i=1}^{d}{x_i}\leq n \right\}\), τότε θα λέμε ότι το \(X\) ακολουθεί την πολυωνυμική κατανομή \(\mathcal{M}^{*}(n,p_1,\ldots,p_d)\) με παραμέτρους \(n\geq 1\), \(p_i>0\) που ικανοποιούν \(0<\sum_{i=1}^{d}{p_i}<1\) και

\[\begin{equation}\label{multi-coeff-6} \mathbf{P}(X_1=x_1,\ldots, X_d=x_d) = \binom{n}{x_1,\ldots,x_d} p_{1}^{x_1}\ldots p_{d}^{x_d} (1-p_1 - \ldots - p_{d})^{n-x_1 - \ldots - x_{d} }, \ \ \textrm{όπου } x \in S_{X}. \end{equation}\]

Παρατήρηση:.

Με τον παραπάνω ορισμό είναι φανερό ότι η διωνυμική κατανομή \(Bin(n,p)\) ταυτίζεται με την \(\mathcal{M}^{*}(n,p)\)

Για \(n=1\), η πολυωνυμική κατανομή \(\mathcal{M}(1,p_1,\ldots,p_d)\) ή \(\mathcal{M}^{*}(1,p_1,\ldots,p_d)\), αναφέρεται ως κατηγορική και θα λέμε ότι το τ.δ. \(C \sim Cat(p_1,\ldots,p_d)\) (\(d \geq 2\)) ή \(C \sim Cat{}^{*}(p_1,\ldots,p_d)\) (\(d \geq 1\)) αντίστοιχα. Η κατηγορική κατανομή γενικεύει την κατανομή Bernoulli, όπου αντί για τον καθορισμό μόνο μιας πιθανότητας επιτυχίας, προσδιορίζει τις πιθανότητες όλων των επιτυχιών \(i\)-είδους. Ένα τ.δ. \(C \sim Cat(p_1,\ldots,p_d)\) παίρνει τιμές στο σύνολο \(\{e_1,\ldots,e_d\}\), δηλαδή στα διανύσματα της ορθοκανονικής βάσης του \(\mathbb{R}^d\) και \(\mathbf{P}(C=e_i)=p_i\) για κάθε \(i=1,\ldots,d\).

Είναι φανερό από τον ορισμό και την ερμηνεία της πολυωνυμικής κατανομής ότι αν \(X\sim \mathcal{M}(n,p_1,\ldots,p_d)\), τότε μπορούμε να έχουμε την εξής χρήσιμη αναπαράσταση \[\begin{equation} X = \sum_{i=1}^{n} C_i, \tag{1.6} \end{equation}\] όπου \(C_i \sim Cat(p_1,\ldots,p_d)\), \(i=1,2,\ldots, n\), και είναι μεταξύ τους ανεξάρτητα τ.δ.. Η έκφραση αυτή του \(X\) που ακολουθεί πολυωνυμική κατανομή ως άθροισμα ανεξάρτητων και ισόνομων κατηγορικών τ.δ. είναι η γενίκευση στα πολυδιάστατα της αντίστοιχης αναπαράστασης μιας τυχαίας μεταβλητής που ακολουθεί τη διωνυμική κατανομή ως άθροισμα ανεξάρτητων και ισόνομων τ.μ. που ακολουθούν κατανομή Bernoulli. Οι αναπαραστάσεις αυτές είναι χρήσιμες, όπως γνωρίζουμε και από τις Πιθανότητες I, για τον υπολογισμό μέσων τιμών και διασπορών.

Πρόταση 1.11 Αν ένα τ.δ. \(X\sim \mathcal{M}(n,p)\) με \(p=(p_1,\ldots,p_d)\), τότε η μέση τιμή του είναι

\[\begin{equation*} \mathbf{E}(X) = np = n\,(p_1,\ldots, p_d) \end{equation*}\]

και η διασπορά του (ο πίνακας διασποράς) είναι

\[\begin{equation*} \mathbf{V}(X) = n\,[\,\text{dg}(p) - p p^{\top}] = n\, \begin{pmatrix} p_1(1-p_1) & -p_1 p_2 & \ldots & -p_1 p_d \\ -p_1 p_2 & p_2(1-p_2) & \ldots & -p_2 p_d \\ \vdots & \vdots & \ddots & \vdots \\ -p_1 p_d & - p_2 p_d= & \ldots & p_d(1-p_d) \end{pmatrix}. \end{equation*}\]

Απόδειξη:. Χρησιμοποιώντας την αναπαράσταση (1.6) έχουμε

\[\begin{equation*} \mathbf{E}(X) = \mathbf{E}\left(\sum_{i=1}^{n} C_i\right) = \sum_{i=1}^{n} \mathbf{E}(C_i) = n\,\mathbf{E}(C), \end{equation*}\]

όπου \(C\sim Cat(p)\). Όμως \(C\in \{e_1,\ldots,e_d\}\) και \(\mathbf{P}(C=e_i)=p_i\), \(1\leq i \leq d\). Επειδή \(\{C_i = 1\}=\{C=e_i\}\) συμπεραίνουμε ότι

\[\begin{equation*} \mathbf{E}(C)=\big(\!\mathbf{E}(C_1),\ldots,\mathbf{E}(C_d)\big)=\big(\!\mathbf{P}(C_1=1),\ldots,\mathbf{P}(C_d=1)\big)=(p_1,\ldots,p_d)=p. \end{equation*}\]

Επίσης, λόγω της ανεξαρτησίας, για τον υπολογισμό της διασποράς έχουμε

\[\begin{equation*} \mathbf{V}(X) = \mathbf{V}\left(\sum_{i=1}^{n} C_i\right) = \sum_{i=1}^{n} \mathbf{V}(C_i) = n\mathbf{V}(C). \end{equation*}\]

Για τον τελευταίο πίνακα έχουμε

\[\begin{equation*} \mathbf{V}(C) = \mathbf{E}(CC^{\top}) - \mathbf{E}(C)\mathbf{E}(C^{\top}) =\text{dg}(p) - p p^{\top}, \end{equation*}\]

χρησιμοποιώντας ότι \(C_i \sim Be(p_i)\), ότι \(C_iC_j=0\) για \(i \neq j\), και άρα

\[\begin{equation*} \mathbf{E}(CC^{\top}) = \begin{pmatrix} \mathbf{E}(C_1^2) & \mathbf{E}(C_1C_2) & \ldots & \mathbf{E}(C_1C_d) \\ \mathbf{E}(C_2C_1) & \mathbf{E}(C_2^2) &\ldots & \mathbf{E}(C_2C_d) \\ \vdots & \vdots & \ddots & \vdots \\ \mathbf{E}(C_dC_1) & \mathbf{E}(C_dC_2) & \ldots & \mathbf{E}(C_d^2) \end{pmatrix} = \begin{pmatrix} p_1 & 0 & \ldots & 0 \\ 0 & p_2 & \ldots & 0 \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \ldots & p_d \end{pmatrix}. \end{equation*}\]

1.3 Εμπειρική Κατανομή

Υπάρχουν πολλές περιπτώσεις που η συνάρτηση κατανομής \(F\), από την οποία προσομοιώνουμε, είναι άγνωστη. Πώς μπορούμε λοιπόν να χρησιμοποιήσουμε τις προσομοιωμένες τιμές για το σκοπό αυτό;

Έστω λοιπόν ότι διαθέτουμε ένα Monte Carlo δείγμα \(x_1,x_2,\ldots,x_n\) με ανεξάρτητες παρατηρήσεις που έχουνε προσομοιωθεί από την \(F\). Η μόνη πληροφορία που έχουμε είναι ότι η κατανομή μπορεί να πάρει αυτές τις τιμές. Αν κάποιος τώρα μας ζητήσει μία τιμή από την κατανομή δεν θα είχαμε κάποιο λόγο να ευνοήσουμε κάποια από αυτές. Θα μπορούσαμε να τις βάλουμε σε μία κληρωτίδα και να τραβήξουμε στην τύχη μία από αυτές. Με άλλα λόγια θα επιλέγαμε κάποια απο αυτές ισοπίθανα. Αυτή η απλή σκέψη μάς οδηγεί στην κατασκευή μίας καινούριας τ.μ. \(X^{*}_{n}\) που έχει τη διακριτή ομοιόμορφη κατανομή στο σύνολο \(\{x_1,x_2,\ldots x_n\}\). Θα ήταν βέβαια ιδιαίτερα επιθυμητό η συνάρτηση κατανομής \(F^{*}_{n}\) της \(X^{*}_{n}\) να προσεγγίζει (με κάποια έννοια) την άγνωστη συνάρτηση κατανομής \(F\) για μεγάλο \(n\). Εφόσον βέβαια η \(X^{*}_{n}\) είναι διακριτή τ.μ. έχουμε ότι \(\forall x\in \mathbb{R}\),

\[\begin{equation}\label{edfr}\displaystyle F^{*}_{n}(x) = \mathbf{P}(X^{*}_{n} \leq x)= \sum_{i: x_i \, \leq \, x } \mathbf{P}(X^{*}_{n} = x_i)= \sum_{i=1}^{n} \frac{1}{n}\,\mathbb{I}_{x_i \, \leq \, x} = \frac{\sum_{i=1}^{n}\mathbb{I}_{x_i \, \leq \, x}}{n}. \end{equation}\]

Είναι φανερό ότι η παραπάνω διαδικασία μας οδηγεί σε μία εκτιμήτρια του \(F(x)\). Συγκεκριμένα, αντικαθιστώντας με τ.μ. ορίζουμε

\[\begin{equation}\label{edf}\displaystyle \mathbb{F}_{n}(x) = \frac{\sum_{i=1}^{n}\mathbb{I}_{X_i \, \leq \, x}}{n}\qquad \forall x\in \mathbb{R}. \end{equation}\]

H \(\mathbb{F}_{n}\) λέγεται εμπειρική συνάρτηση κατανομής. Κάθε πραγματοποίηση \(F^{*}_{n}\) της \(\mathbb{F}_{n}\) αντιστοιχεί σε μία συνάρτηση κατανομής όπως προαναφέραμε και άρα παίρνει τιμές στο χώρο συναρτήσεων \(\mathcal{F}\). Μπορούμε λοιπόν να σκεφτόμαστε την \(\mathbb{F}_{n}\) ως μία τυχαία συνάρτηση του \(x\) ή ισοδύναμα ως μία τυχαία μεταβλητή με τιμές συναρτήσεις στον χώρο \(\mathcal{F}\). Αξίζει βέβαια να μελετηθούν οι οριακές ιδιότητες της \(\mathbb{F}_{n}\). Μας ενδιαφέρει λοιπόν να δούμε αν και με ποιό τρόπο συγκλίνει η \(\mathbb{F}_{n}\) στην \(F\).

1.3.1 Σημειακές ιδιότητες της εμπειρικής συνάρτησης κατανομής

Είδαμε ότι τη συνάρτηση κατανομής \(F\) μπορούμε να την εκτιμήσουμε με την εμπειρική συνάρτηση κατανομής \(\mathbb{F}_n\). Εξετάζουμε πρώτα τις σημειακές ιδιότητες της \(\mathbb{F}_n\).

Πρόταση 1.12 Για κάθε \(x\in\mathbb{R}\) ισχύει ότι \(n\,\mathbb{F}_n(x)\sim\text{Bin}(n, F(x))\).

Απόδειξη:. Έχουμε ότι \[\begin{equation}\label{edf-as-sample-mean} \mathbb{F}_n(x)=\dfrac{1}{n}\sum\limits_{k=1}^{n}\textbf{1}_{(-\infty, x]}(X_k)=\dfrac{1}{n}\sum\limits_{k=1}^{n}Y_k, \end{equation}\] όπου \(Y_k=\textbf{1}_{(-\infty, x]}(X_k)\) για κάθε \(1\leq k \leq n\). Είναι φανερό ότι \(Y_k\sim \text{Be}(F(x))\) για κάθε \(1\leq k \leq n\), και οι \(Y_1, \dots, Y_n\) είναι ανεξάρτητες τυχαίες μεταβλητές, αφού \(Y_k\in\{0, 1\}\) και ισχύει ότι \(\textbf{P}_F(Y_k=1)=\textbf{P}_F(X_k\leq x)=F(x)\), ενώ η ανεξαρτησία των \(Y_1, \dots, Y_n\) έπεται από την ανεξαρτησία των \(X_1, \dots, X_n\). Από τη σχέση (\(\ref{edf-as-sample-mean}\)) συμπεραίνουμε ότι \[n\,\mathbb{F}_n(x)=\sum\limits_{k=1}^{n}Y_k\sim \text{Bin}(n, F(x))\] ως άθροισμα \(n\) το πλήθος ανεξάρτητων τυχαίων μεταβλητών από την κατανομή \(\text{Be}(F(x))\). Το ζητούμενο έπεται.

Πόρισμα 1.4 Έστω \(F\) συνάρτηση κατανομής. Ισχύουν τα εξής:

- \(\mathbf{E}_F(\mathbb{F}_n(x))=F(x)\), για κάθε \(x\in\mathbb{R}\).

- \(\textbf{V}_F(\mathbb{F}_n(x))=\dfrac{F(x)(1-F(x))}{n}\), για κάθε \(x\in\mathbb{R}\).

Παρατήρηση:.

Ο δείκτης \(F\) στα \(\mathbf{E}_F\) και \(\textbf{V}_F\) που μπαίνουν στη μέση τιμή και τη διασπορά αφορούν τον υπολογισμό, αντίστοιχα, μέσης τιμής και διασποράς με \(X_1, \dots, X_n\sim F\) και συνήθως θα παραλείπεται.

Το παραπάνω πόρισμα εκφράζει την αμεροληψία της \(\mathbb{F}_n(x)\) ως εκτιμήτριας του \(F(x)\), για κάθε \(x\in \mathbb{R}\). Αυτό φαίνεται από τη σχέση (i). Από τη σχέση (ii) και τη σχέση (i) συμπεραίνουμε ότι είναι και συνεπής εκτιμήτρια του \(F(x)\), για κάθε \(x\in\mathbb{R}\). Πράγματι, ισχύει ότι \(\mathbf{V}(\mathbb{F}_n(x))\rightarrow 0\) και η \(\mathbb{F}_n(x)\) είναι αμερόληπτη εκτιμήτρια του \(\mathbb{F}(x)\). Αυτό το αποτέλεσμα μπορούμε να το δείξουμε και ανεξάρτητα. Μάλιστα, όπως φαίνεται στην επόμενη πρόταση, έχουμε ισχυρή συνέπεια.

Πρόταση 1.13 Για κάθε \(x\in\mathbb{R}\) ισχύει ότι \(\mathbb{F}_n(x)\stackrel{a.s.}{\longrightarrow}F(x)\).

Για κάθε \(x\in\mathbb{R}\) ισχύει ότι \(\sqrt{n}\,\left( \mathbb{F}_n(x)-F(x) \right) \stackrel{d}{\longrightarrow} \mathcal{N}\Big(0,\, F(x)(1-F(x)) \Big)\).

1.3.2 Ομοιόμορφη σύγκλιση της εμπειρικής συνάρτησης κατανομής

Τα παραπάνω αποτελέσματα μας δείχνουν τη σημειακή συμπεριφορά της εκτιμήτριας \(\mathbb{F}_n(x)\) της \(F\), δηλαδή το πώς συμπεριφέρονται οι ακολουθίες των τυχαίων μεταβλητών \(\mathbb{F}_n(x)\) για κάθε \(x\in\mathbb{R}\). Η \(\mathbb{F}_n\) είναι μία συλλογή τυχαίων μεταβλητών \(\{\mathbb{F}_n(x)\}_{x\in\mathbb{R}}\), οι οποίες είναι συσχετισμένες. Στην πραγματικότητα με το Monte Carlo δείγμα μπορούμε να προσεγγίσουμε όχι μόνο κατά σημείο αλλά και ομοιόμορφα. Σχετικά, είναι γνωστό το παρακάτω θεώρημα.

Θεώρημα 1.7 (Glivenko-Cantelli) Η εμπειρική συνάρτηση κατανομής \(\mathbb{F}_{n}\) συγκλίνει με πιθανότητα 1 ομοιόμορφα στην \(F\), δηλαδή,

\[\begin{equation}\label{unif-conv} \sup_{x\in\mathbb{R}}|\mathbb{F}_{n}-F| \xrightarrow[]{a.s.} 0. \end{equation}\]

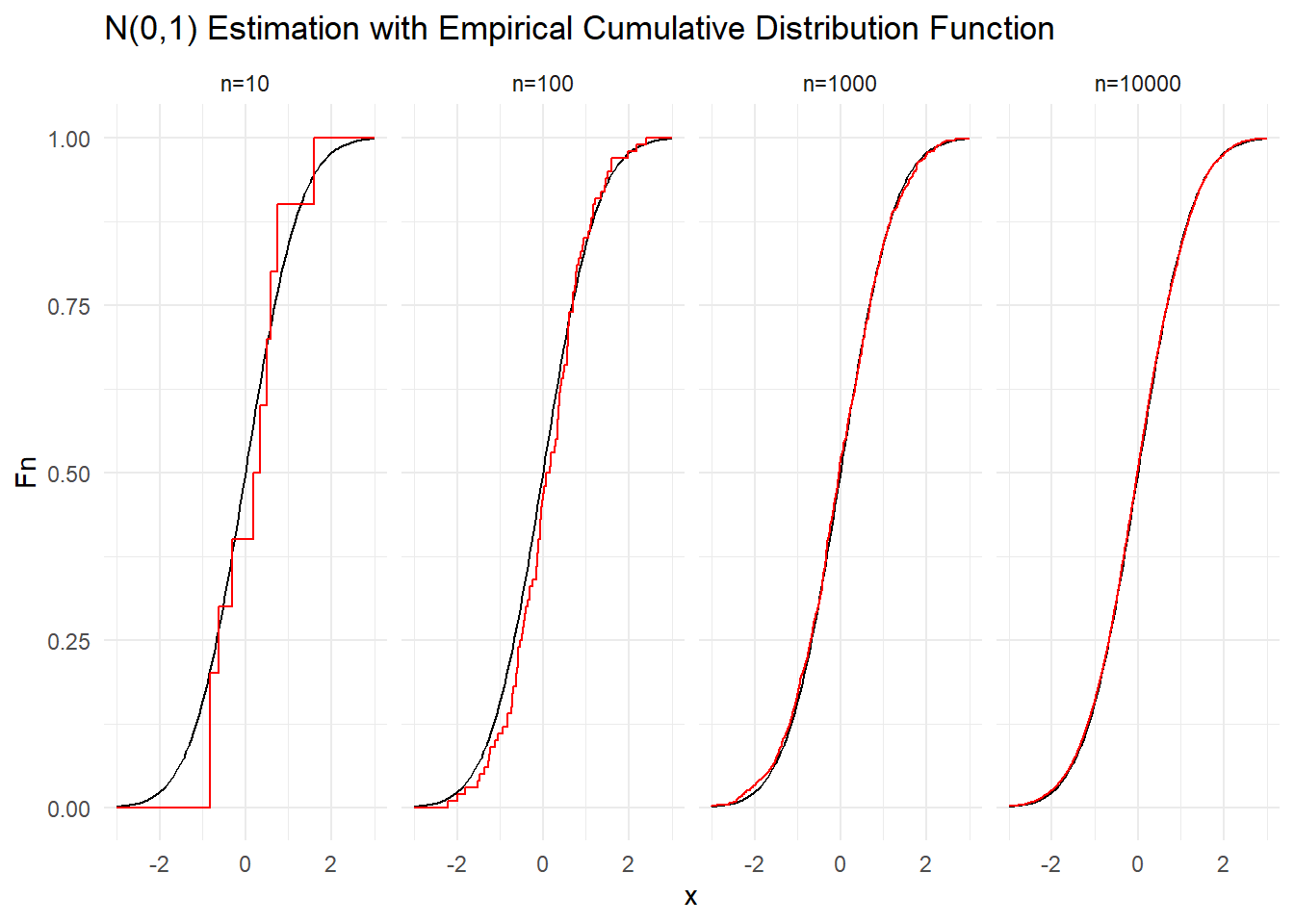

Παράδειγμα 1.3 Ας επαληθεύσουμε την σύγκλιση της \(\mathbb{F}_{n}\) στην \(F\) παίρνοντας όλο και μεγαλύτερα Monte Carlo δείγματα από την \(\mathcal{N}(0,1)\). Συγκεκριμένα, προσομοιώνουμε δείγματα μεγέθους \(n=10, 100, 1000\) και \(10000\).

Στα παρακάτω γραφήματα βλέπουμε μία πραγματοποίηση της εξέλιξης της εμπειρικής σ.κ. (κόκκινο), καθώς το μέγεθος του Monte Carlo δείγματος της \(N(0,1)\) αυξάνει, μαζί με τη θεωρητική συνάρτηση κατανομής (μαύρο) της τυποποιημένης κανονικής κατανομής \(N(0, 1)\). Βλέπουμε ότι με δείγμα μεγέθους \(n=10\) η προσέγγιση της θεωρητικής από την εμπειρική σ.κ. δεν είναι καλή, βελτιώνεται αισθητά με \(n=100\), δύσκολα ξεχωρίζουμε τις καμπύλες με \(n=1000\) , ενώ με \(n=10000\) σχεδόν επιτυγχάνεται ταύτιση.